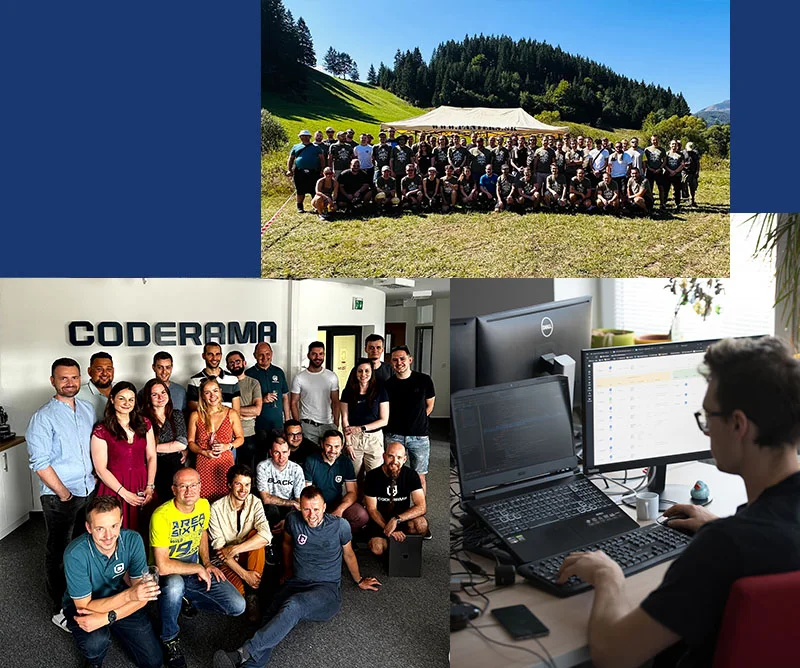

Preto ti ponúkame okrem skvelých BENEFITOV aj adekvátne platové ohodnotenie. Vyplň náš dotazník a my ti na základe tvojich skúseností vypracujeme odhad tvojej budúcej výplaty v CODERAMA.

Proces crawl sa realizuje pomocou automatizovaných programov nazývaných "crawlers" alebo "spiders", ktoré prechádzajú cez webové stránky a sledujú odkazy na iné stránky. Crawlery používajú špeciálne algoritmy a pravidlá na určenie, ktoré stránky majú byť prehľadávané, ako často majú byť navštevované a aké informácie majú byť získané.

Crawling sa začína z jednej počiatočnej URL adresy, často nazývanej aj "seed". Crawler navštívi túto počiatočnú adresu a extrahuje odkazy na iné stránky. Potom pokračuje v prechádzaní týchto odkazov a opakuje proces pre ďalšie stránky. Týmto spôsobom crawler postupne prechádza cez veľké množstvo webových stránok a získava ich obsah.

Počas crawl procesu crawler získava rôzne informácie zo stránok, ako sú textový obsah, nadpisy, odkazy, obrázky a ďalšie dôležité atribúty. Tieto informácie sú potom použité na aktualizáciu vyhľadávacieho indexu, kde sa ukladajú a spracovávajú pre ďalšie vyhľadávacie dotazy.

Crawling je kľúčovým procesom pre fungovanie vyhľadávačov, pretože umožňuje vyhľadávačom objaviť nový obsah na webe a udržiavať si aktuálny stav indexu. Vyhľadávače pravidelne vykonávajú crawl, aby mohli získať čo najaktuálnejšie informácie o webe a poskytovať používateľom najnovšie výsledky vyhľadávania.

Crawl proces môže byť ovplyvnený rôznymi faktormi, ako sú súbor robots.txt, ktorý definuje pravidlá pre prehľadávanie webových stránok, a súbor sitemap, ktorý poskytuje mapu stránok na webe. Weboví majitelia môžu tiež špecifikovať preferencie pre crawlery pomocou špecifických značiek a hlavičiek v HTML kóde.

Hlavným miestom, kde je crawl využívaný, sú vyhľadávače ako Google, Bing, Yahoo a ďalšie. Crawling umožňuje vyhľadávačom prechádzať webové stránky, získavať ich obsah a aktualizovať vyhľadávací index, aby mohli poskytovať relevantné výsledky vyhľadávania.

Pre optimalizáciu webových stránok a zlepšenie ich viditeľnosti vo vyhľadávačoch je dôležité mať správne prehľadávané stránky. Crawlery pomáhajú zistiť, aké stránky a obsah sú dostupné na webe, a tým umožňujú optimalizovať obsah, kľúčové slová a ďalšie faktory pre lepšie zaradenie vo výsledkoch vyhľadávania.

Crawlery sa často používajú aj v rámci webovej analýzy, aby sa získali dáta o stránkach, ich štruktúre a obsahu. Tieto dáta môžu byť využité na rôzne účely, ako je monitorovanie vývoja webového obsahu, získavanie štatistík o návštevnosti stránok, sledovanie konkurencie a ďalšie.

V e-shope je crawl využívaný na monitorovanie cien, dostupnosti produktov a informácií o produktoch na rôznych webových stránkach. Crawlery môžu automaticky prechádzať e-shopy a získavať relevantné informácie pre porovnanie cien a zobrazenie aktuálnych údajov používateľom.

Crawlery sa používajú na sledovanie správnych portálov, sociálnych médií a iných online médií. Pomocou crawl procesu je možné získať a analyzovať články, diskusie, komentáre a iné informácie, ktoré sa týkajú určitého obsahu alebo témy.